Mixtral:数据流中的生成式稀疏专家混合模型

发布于2025-01-14 阅读(0)

发布于2025-01-14 阅读(0)

扫一扫,手机访问

想了解更多AIGC的内容,请访问:

51CTO AI.x社区

https://www.51cto.com/aigc/

Cloudera公司数据流首席工程师Tim Spann 表示,Mixtral-8x7B大型语言模型(LLM)是一个预先训练的生成式稀疏专家混合模型。

他表示,这款模型非常有趣,也很容易理解。在适当的指导下,它似乎表现很好。而通过例子,他并不确定Mixtral-8x7B是否比Google Gemma、Meta LLAMA2或OLLAMA Mistral更好。

Spann撰写的文章将展示如何使用Mixtral LLM,只需要几个步骤就可以针对文本输入运行Mixtral LLM。

该模型可以由轻量级无服务器REST API或Transformer库运行。也可以使用GitHub存储库,其场景最多可容纳32000个令牌。开发人员还可以输入英语、意大利语、德语、西班牙语和法语的提示。关于如何利用这一模型有很多选择项,而本文将展示如何利用Apache NiFi系统构建实时LLM通道。

开发人员需要决定的一个关键问题是将使用什么样的输入(聊天、代码生成、问题答案、文档分析、摘要等)。一旦决定输入,需要创建一些提示,并且进行调整。文中将提供一些指导,帮助提高快速构建技能的能力。Spann在其培训教程中介绍了一些基本的提示工程。

构建最佳提示的指南

提示符的构建对于使其正常工作非常关键,因此使用Apache NiFi系统构建提示符。

流程概述

步骤1:创建并格式化提示符

在构建应用程序时,以下是将要使用的基本提示模板。

提示模板

{ "inputs": "<s>[INST]Write a detailed complete response that appropriately answers the request.[/INST][INST]Use this information to enhance your answer: ${context:trim():replaceAll('"',''):replaceAll('\n', '')}[/INST] User: ${inputs:trim():replaceAll('"',''):replaceAll('\n', '')}</s>" }复制

将在ReplaceText处理器的替换值字段中输入这个提示符。

步骤2:构建对HuggingFace REST API的调用,根据模型进行分类

在数据流中添加一个InvokeHTTP处理器,将HTTP URL设置为Mixtral API URL。

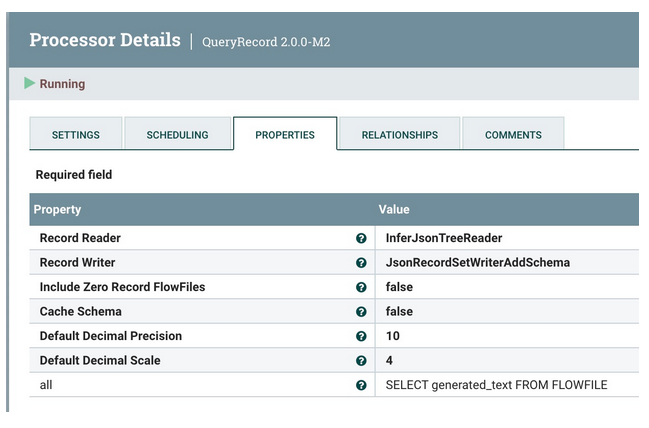

步骤3:查询转换和清理结果

使用QueryRecord处理器来清理和转换抓取generated_text字段的HuggingFace结果。

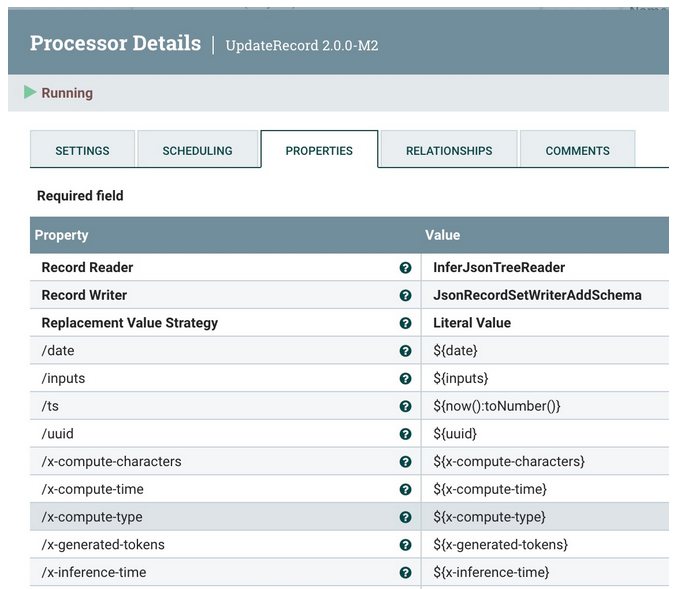

步骤4:添加元数据字段

使用UpdateRecord处理器来添加元数据字段、JSON读取器和写入器,以及文字值替换值策略(Literal Value Replacement Value Strategy)。而正在添加的字段是添加属性。

发送到Kafka和Slack的概述。

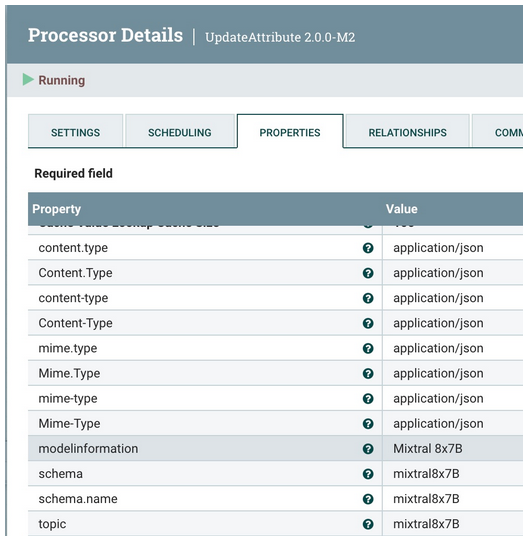

步骤5:将元数据添加到数据流

使用UpdateAttribute处理器来添加正确的“application/json Content Type”,并将模型类型设置为Mixtral。

步骤6:将清理后的记录发送到Kafka Topic

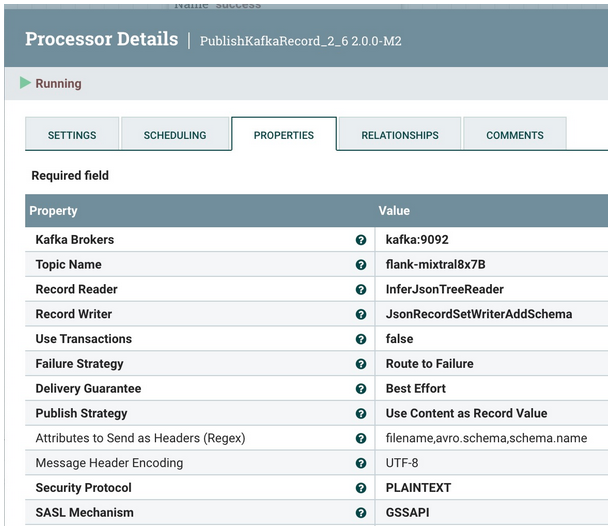

将它发送到本地Kafka代理(可能是Docker或其他)和flank-mixtral8x7B主题。如果不存在,NiFi和Kafka会自动创建一个。

步骤7:重新尝试发送

如果出现问题,将尝试重新发送三次,然后中止。

将数据推送到Slack的概述。

步骤8:将相同的数据发送到Slack供用户回复

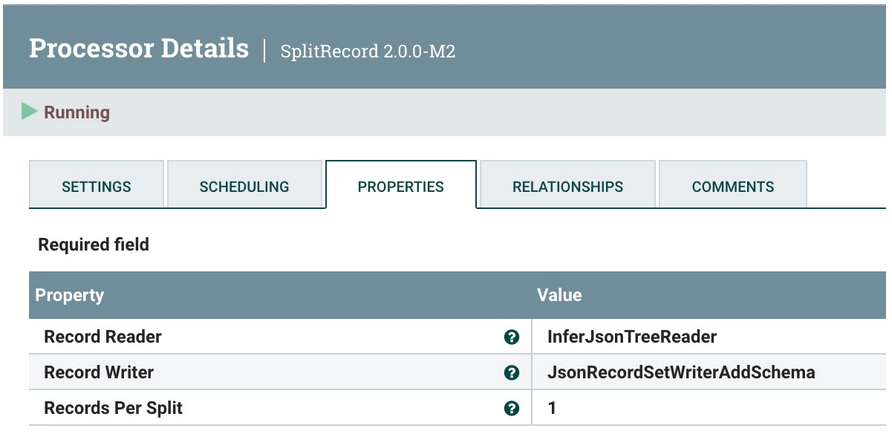

第一步是拆分为单个记录,每次发送一个记录。为此使用SplitRecord处理器。

和以前一样,重用JSON树读取器和JSON记录集编写器。像往常一样,选择“1”作为“每次拆分的记录”。

步骤9:使生成的文本可用于消息传递

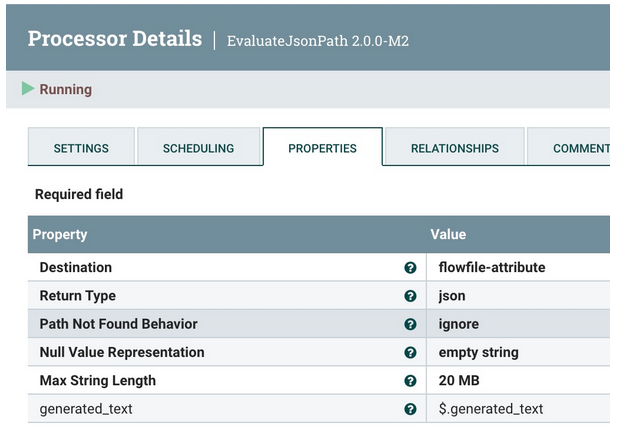

使用EvaluateJsonPath从Mixtral (on HuggingFace)提取生成的文本。

步骤10:将回复发送到Slack

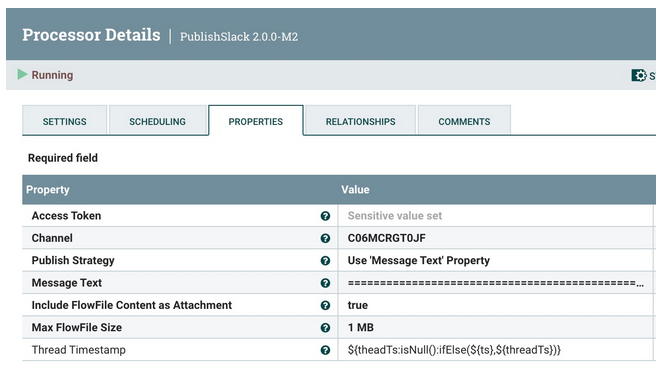

使用PublishSlack处理器,这是Apache NiFi 2.0的新功能。这需要设定频道名称或频道ID。选择使用“Message Text”属性的发布策略。对于消息文本,使用下面的Slack Response模板。

对于用户的最终回复需要一个 Slack 响应模板,该模板的格式应符合需要的沟通方式。以下是一个具有基本功能的示例。

Slack响应模板===============================================================================================================HuggingFace ${modelinformation} Results on ${date}:Question: ${inputs}Answer:${generated_text}=========================================== Data for nerds ====HF URL: ${invokehttp.request.url}TXID: ${invokehttp.tx.id}== Slack Message Meta Data ==ID: ${messageid} Name: ${messagerealname} [${messageusername}]Time Zone: ${messageusertz}== HF ${modelinformation}Meta Data ==Compute Characters/Time/Type: ${x-compute-characters} / ${x-compute-time}/${x-compute-type}Generated/Prompt Tokens/Time per Token: ${x-generated-tokens} / ${x-prompt-tokens} : ${x-time-per-token}Inference Time: ${x-inference-time}// Queue Time: ${x-queue-time}Request ID/SHA: ${x-request-id} / ${x-sha}Validation/Total Time: ${x-validation-time} / ${x-total-time}===============================================================================================================运行这一程序时,它将看起来像Slack中的下图。

现在已经向 Hugging Face 发送了提示,让它针对 Mixtral 运行,将结果发送到 Kafka,并通过 Slack 回复用户。

现在已经用零代码完成了完整的Mixtral应用程序。

结论

现在,已经使用Apache NiFi、HuggingFace和Slack构建了一个完整的往返程序,以使用新的Mixtral模型构建聊天机器人。

学习摘要

- 学会了如何为HuggingFace Mixtral建立一个提示

- 学习如何清理数据流

- 构建一个可以重用的HuggingFace REST调用

- 处理HuggingFace模型调用结果

- 发送第一条 Kafka 消息

- 格式化和构建Slack调用

- 为生成式人工智能构建一个完整的数据流

如果需要使用新的Apache NiFi 2.0的其他教程,可以查看:

以下是有关构建Slack机器人的更多信息:

- Building a Real-Time Slackbot With Generative AI

- Building an LLM Bot for Meetups and Conference Interactivity

Tim Spann正在编写Apache NiFi 2和生成式人工智能教程。

以下是他提供的一些资源:

Invoke the Mixtral 8x7B model on Amazon Bedrock for text generation

Running Mixtral 8x7b on M1 16GB

Mixtral-8x7B: Understanding and Running the Sparse Mixture of Experts by Mistral AI

Retro-Engineering a Database Schema: Mistral Models vs. GPT4, LLama2, and Bard (Episode 3)

Comparison of Models: Quality, Performance & Price Analysis

A Beginner’s Guide to Fine-Tuning Mixtral Instruct Model

原文标题:Mixtral: Generative Sparse Mixture of Experts in DataFlows,作者:Tim Spann

链接:https://dzone.com/articles/mixtral-generative-sparse-mixture-of-experts-in-da。

想了解更多AIGC的内容,请访问:

51CTO AI.x社区

https://www.51cto.com/aigc/

上一篇:炒币主流平台是什么

产品推荐

-

售后无忧

立即购买>- DAEMON Tools Lite 10【序列号终身授权 + 中文版 + Win】

-

¥150.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Ultra 5【序列号终身授权 + 中文版 + Win】

-

¥198.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Pro 8【序列号终身授权 + 中文版 + Win】

-

¥189.00

office旗舰店

-

售后无忧

立即购买>- CorelDRAW X8 简体中文【标准版 + Win】

-

¥1788.00

office旗舰店

-

正版软件

正版软件

- 币圈资讯平台有哪些?币圈专业资讯平台推荐

- 获取加密货币市场动态的推荐平台有:CoinMarketCap:实时价格和广泛的数据CoinGecko:深入的分析和新兴加密货币BinanceInfo:行业新闻和币安项目CryptoSlate:独家报道和观点多样性Blockworks:高质量记者报道和教育内容TheBlock:机构投资者新闻和独家数据Cointelegraph:国际记者团队和全球市场视角Decrypt:深入报道和原创视频内容

- 7分钟前 0

-

正版软件

正版软件

- 中移物联推出“防堵疏监管”五位一体电动自行车安全充电解决方案

- “锵锵一拧,‘咣’的一声,轻轻一拧油门,便可轻松前行,既省力又省时。在国家大力推倡绿色低碳环保的背景下,电动自行车已成为广大市民短途出行的重要方式之一。据国家应急管理部公布数据,目前我国电动自行车保有量已达3.5亿辆。”某社区车库安装的和易充安全充电桩“充电太难了,家住6楼,楼下没有集中充电,家里充电又担心安全问题。”一位小区居民说道。随着电动自行车的普及,小区电动车的充电问题也日益突出,由电动车充电引发的火灾事故也频频发生。因此,规范电动车停放及安全充电管理迫在眉睫。针对现有电动自行车充电安全的痛点问题

- 17分钟前 0

-

正版软件

正版软件

- 小米规划上海总部地块被收回?徐汇区:该地块已由商办混合用地调整为住宅用地

- 本站5月23日消息,近日,小米于三年前摘得的上海徐汇滨江一宗商业办公用地发生变更引发关注。"小米公司发言人昨天已经对此事进行了回应,称小米在上海的经营发展顺利,徐汇区斜土街道xh128D-07地块的相关事宜系根据发展需求,按程序落实。"据报道,上海市徐汇区官方对此表示:5月20日徐汇区规划和自然资源局已对《上海市徐汇区黄浦江南延伸段WS3单元控制性详细规划xh128D街坊部调整》公众参与草案进行公示。根据公示内容,xh128D街坊位于徐汇区斜土街道南部,黄浦江南延伸段WS3单元内。东至先丰路,西至大木桥路

- 37分钟前 小米 上海 0

-

正版软件

正版软件

- okex怎么开通合约

- 在OKX开通合约交易的步骤:注册并验证账户激活合约交易填写申请表完成风险评估等待审核开通合约交易

- 57分钟前 0

-

正版软件

正版软件

- 揭开大型语言模型(LLM)的力量:初创企业如何通过精简集成彻底改变运营方式

- 大型语言模型(LLM)已成为各种规模企业的游戏规则改变者,但它们对初创企业的影响尤为显著。为了理解其中的原因,让我们来看看初创企业相对于老牌企业有哪些优势,以及为什么AI是它们的重要推动力。首先,与传统企业相比,初创企业有更大的灵活性。它们通常没有过多的层级和繁琐的决策程序,可以更迅速地适应市场变化和顾客需求。这种敏捷性使得初创企业能够更快地推出新产品和服务,并灵活调整战略。其次,初创企业通常更加创初创企业往往面临预算有限、时间紧迫的局面,即便是规模更大的行业参与者也可能争夺的是规模更大的行业参与者可能争

- 1小时前 05:34 人工智能 大型语言模型 0