英伟达发布人工智能芯片HGX H200

发布于2023-11-17 阅读(0)

发布于2023-11-17 阅读(0)

扫一扫,手机访问

据外媒报道,当地时间周一,英伟达发布了人工智能(AI)芯片HGX H200,该GPU利用Hopper架构来加速人工智能应用。

据外媒报道,H200是去年发布的H100 GPU的后续产品。H100是英伟达首款基于Hopper架构打造的GPU,此前是英伟达最强大的人工智能GPU芯片。

英伟达称,H200是首款提供HBM3e内存的GPU。得益于HBM3e, H200可提供141GB内存和每秒4.8TB的带宽,可加速生成式人工智能和大型语言模型(LLM),同时可以处理人工智能和超级计算工作负载所需的大量数据。

该公司还表示,H200的推出将带来进一步的性能飞跃,包括在Llama 2(一个具有700亿参数的LLM)上的推理速度比 H100快了近一倍。预计在未来的软件更新中,H200的性能将进一步领先和提高。

英伟达表示,全球系统制造商和云服务提供商将从2024年第二季度开始使用H200。

免责声明:

1、本号不对发布的任何信息的可用性、准确性、时效性、有效性或完整性作出声明或保证,并在此声明不承担信息可能产生的任何责任、任何后果。

2、 本号非商业、非营利性,转载的内容并不代表赞同其观点和对其真实性负责,也无意构成任何其他引导。本号不对转载或发布的任何信息存在的不准确或错误,负任何直接或间接责任。

3、本文部分资料、素材、文字、图片等来源于互联网,所有转载都已经注明出处。如果您发现有侵犯您的知识产权以及个人合法权益的作品,请与我们联系,我们会及时进行修改或删除

本文转载于:https://www.sohu.com/a/736514683_100270403?scm=1102.xchannel:676:110036.0.1.0~9010.8000.0.0.1829 如有侵犯,请联系admin@zhengruan.com删除

产品推荐

-

售后无忧

立即购买>- DAEMON Tools Lite 10【序列号终身授权 + 中文版 + Win】

-

¥150.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Ultra 5【序列号终身授权 + 中文版 + Win】

-

¥198.00

office旗舰店

-

售后无忧

立即购买>- DAEMON Tools Pro 8【序列号终身授权 + 中文版 + Win】

-

¥189.00

office旗舰店

-

售后无忧

立即购买>- CorelDRAW X8 简体中文【标准版 + Win】

-

¥1788.00

office旗舰店

-

正版软件

正版软件

-

正版软件

正版软件

- usdt属于什么币种怎么来的

- USDT是TetherUSD的缩写,是一种挂钩美元的稳定币,其价值始终与美元保持1:1的锚定关系。USDT是由TetherLimited公司发行,据称每发行一个USDT,就在其银行账户中存入1美元作为抵押。USDT作为一种稳定币,价值不会大幅波动,并且被广泛接受,但其准备金的透明度和流动性一直存在争议。

- 7分钟前 0

-

正版软件

正版软件

- BNX币交易所全览及交易指南

- BNX 币可以在多个交易所交易,包括中心化交易所如 Binance、Huobi Global、OKEx、FTX、Bitfinex,以及去中心化交易所如 PancakeSwap、ApeSwap、SushiSwap、1inch Network、Binance DEX。BNX 币的交易表现稳健,目前价格为 1.0010676009018 美元,尽管近期略有下跌,但交易量和流通市值依然强劲,显示出市场对 BNX 的持续需求。

- 9分钟前 0

-

正版软件

正版软件

- 欧易交易所网络密码重置指南

- 在欧易交易所重置网络密码可以通过访问网站、点击“忘记密码?”链接、选择“网络密码”选项、输入邮箱地址获取验证码、输入验证码并设置新密码、确认新密码后点击“重置密码”按钮来完成。整个过程简单易行,确保使用安全的密码并定期更改以保障账户安全。

- 16分钟前 0

-

正版软件

正版软件

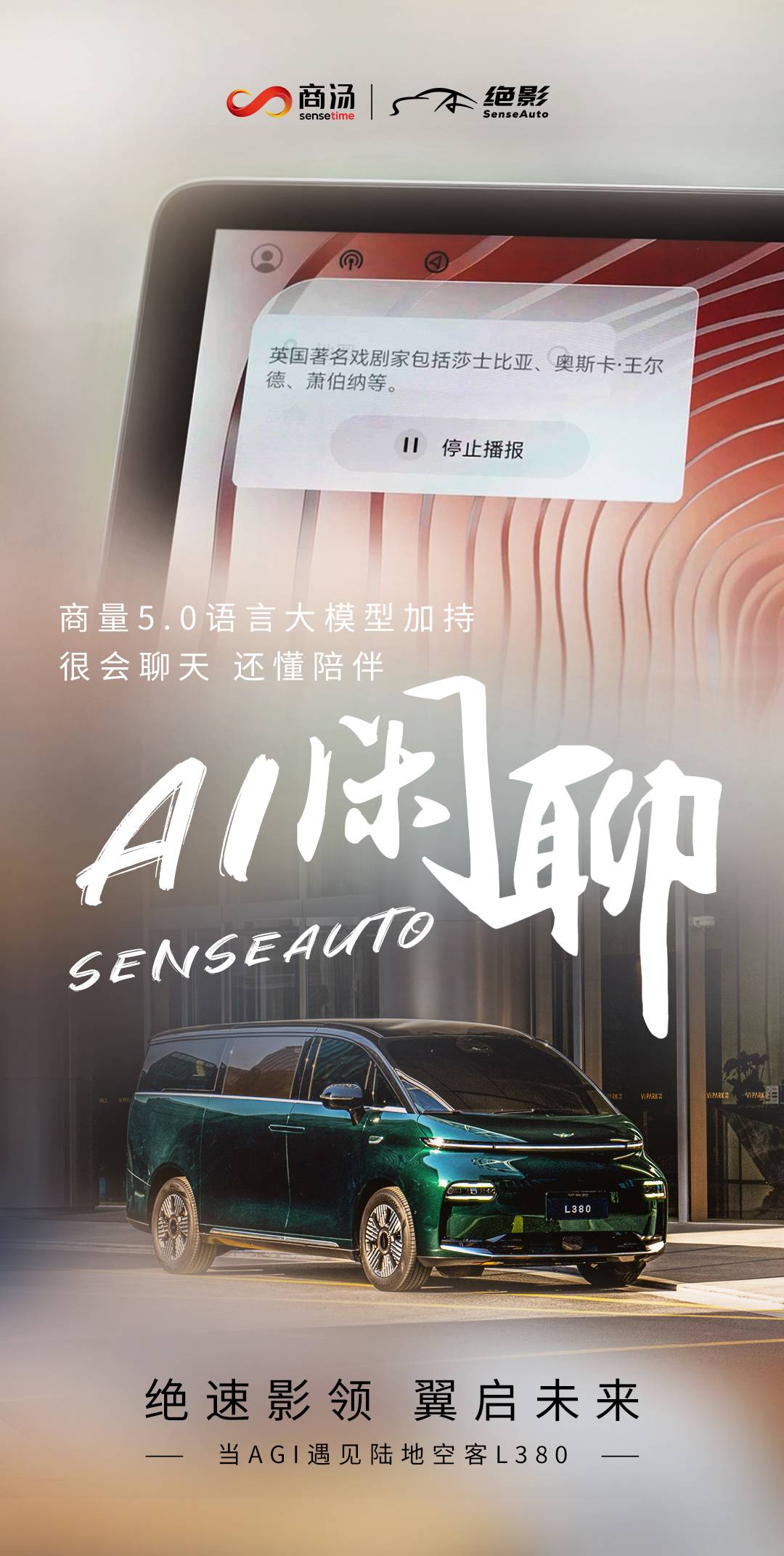

- 当AGI遇见「陆地空客」,商汤绝影大模型上车LEVC

- 6月25日,吉利集团旗下子品牌翼真汽车(LEVC)旗下首款豪华纯电MPV翼真L380在浙江乌镇正式上市发布,这款拥有空客级空间、空客级豪华、空客级续航、空客级安全的翼真L380被称为「陆地空客」。依托AI大模型上车,翼真L380为用户打造了创新的智能座舱体验。作为中国智能座舱的领军企业,商汤绝影与LEVC翼真汽车强强联手,助力AI大模型上车翼真L380,提供「AI闲聊」、「美图壁纸」和「童话绘本」等行业领先的AI大模型座舱解决方案。近期在多个权威榜单评测中,商汤「日日新5.0」大模型多项指标超越GPT-4

- 22分钟前 产业 智能汽车 商汤科技 预训练大模型 0

最新发布

-

1

1

- 阿里追捧的中台,“热度”退了?

- 1973天前

-

2

2

- Overture设置踏板标记的方法

- 1810天前

-

3

3

- 思杰马克丁取得CleanMyMac中国区独家发行授权

- 1800天前

-

4

4

- IBM:20万台Mac让公司职工在工作中更快乐 更多产

- 1998天前

-

5

5

- 报道称微软一直在悄然游说反对“维修权”立法!

- 1964天前

-

6

6

- 美国怀疑华为窃取商业机密 华为:身正不怕影子斜

- 1960天前

-

7

7

- 三星被曝正与联发科接洽 A系列手机有望搭载其5G芯片

- 1975天前

-

8

8

- 环球墨非完成千万级融资 联合企业集团投资

- 1996天前

-

9

9

相关推荐

热门关注

-

- Xshell 6 简体中文

- ¥899.00-¥1149.00

-

- DaVinci Resolve Studio 16 简体中文

- ¥2550.00-¥2550.00

-

- Camtasia 2019 简体中文

- ¥689.00-¥689.00

-

- Luminar 3 简体中文

- ¥288.00-¥288.00

-

- Apowersoft 录屏王 简体中文

- ¥129.00-¥339.00